🤖 Éthique, sécurité et précautions d’usage de l’IA en éducation

Je dois l’avouer : j’ai moi-même été prise par l’effet « Whaou » face aux capacités de l’IA générative. Comme beaucoup d’enseignants, j’ai été éblouie par les possibilités offertes par ces outils révolutionnaires. Il m’a fallu pas mal de temps pour redescendre sur Terre !

Cet article me tient particulièrement à cœur car il représente le fruit d’un cheminement personnel et professionnel. Je remercie sincèrement toutes les personnes autour de moi qui ont su contenir mon enthousiasme initial et m’aider à prendre le recul nécessaire pour percevoir les zones d’ombre derrière cette technologie fascinante.

Dans cette page, je vous propose donc un tour d’horizon des points de vigilance essentiels pour intégrer l’IA dans les pratiques pédagogiques, en toute conscience… et sans jamais perdre de vue la boussole éducative. Car c’est bien de cela qu’il s’agit : transformer notre fascination en sagesse pédagogique.

🎯 Ma vision

Dans cette page, je vous propose un tour d’horizon des points de vigilance essentiels pour intégrer l’IA dans les pratiques pédagogiques, en toute conscience… et sans jamais perdre de vue la boussole éducative.

Sources médiatiques et actualité :

- Podcast « This Past Weekend w/Theo Von » (23 juillet 2025) – Interview de Sam Altman sur la confidentialité des échanges IA.

Cliquez pour agrandir

🎯 L’IA est entraînée… sur des données biaisées

Quand une IA donne une réponse, elle s’appuie sur des millions de textes préexistants. Le souci ? Ces textes peuvent véhiculer des stéréotypes : sexistes, validistes, culturels, etc.

💡 Réflexe à adopter

Analyser une réponse d’IA avec vos élèves. Y a-t-il des idées préconçues ? Qui est inclus ? Qui est oublié ?

✅ En formation

Proposer une activité sur la notion de biais algorithmique, avec des exemples concrets (métier genré, prénom associé à une origine…).

⚠️ Risques identifiés par la recherche

Les systèmes d’IA peuvent reproduire et amplifier les discriminations présentes dans les données d’entraînement, créant des biais systémiques dans :

- L’évaluation des performances des élèves

- Les recommandations pédagogiques personnalisées

- La sélection de ressources éducatives

- L’orientation scolaire et professionnelle

🌀 Une IA peut… halluciner

Oui, halluciner. C’est le terme utilisé pour désigner une IA qui invente une réponse qui semble crédible… mais qui est totalement fausse.

Exemples réels :

- Une date d’événement inventée

- Une loi citée qui n’existe pas

- Un lien vers un article… inexistant

💬 Ce que je recommande

- Toujours vérifier les infos importantes

- Utiliser des outils qui intègrent la recherche web vérifiable, comme WebChatGPT ou Perplexity

- Initier les élèves à la vérification croisée des sources. C’est une compétence numérique essentielle

❌ Erreurs critiques observées

Les recherches montrent que l’IA n’a jamais été entraînée à distinguer le vrai du faux avant de faire appel à sa capacité de calcul. Internet regorgeant de fausses informations, l’IA peut reproduire :

- Des tentatives de manipulation ou de discrimination

- Des avis donnés par des personnes incompétentes

- Des certitudes érigées en principes sans fondement

🔐 Données personnelles : terrain sensible

🚨 Alerte du PDG d’OpenAI (juillet 2025)

Sam Altman, patron d’OpenAI, a expliqué dans le podcast « This Past Weekend w/Theo Von » (épisode #599, 23 juillet 2025) l’absence de protection juridique :

« There’s doctor-patient confidentiality… And we haven’t figured that out yet for when you talk to ChatGPT… we could be required to produce [the chats]… I think that’s very screwed up. »

Traduction : « Il y a la confidentialité médecin-patient… Et nous n’avons pas encore résolu cela quand vous parlez à ChatGPT… nous pourrions être tenus de produire [les conversations]… Je pense que c’est très problématique. »

En classe : Cette déclaration officielle confirme l’absence de cadre juridique protecteur pour les échanges avec l’IA !

❌ Erreur fréquente

Saisir des noms, des prénoms, des copies, des notes dans un outil d’IA ? Non.

Les IA grand public stockent parfois les données pour « améliorer le modèle », et certaines entreprises sont soumises à des lois extraterritoriales comme le Cloud Act ou le Patriot Act.

⚠️ Vide juridique : l’absence de confidentialité légale

Contrairement aux professions à secret (médecin, avocat, psychologue), aucune protection juridique ne couvre les échanges avec les IA conversationnelles.

- OpenAI pourrait être tenu de produire les conversations en cas de procédure judiciaire

- Les données peuvent être utilisées pour l’entraînement des modèles

- Aucun « secret professionnel » ne protège vos échanges

✅ Ce qu’on peut faire en toute sécurité

- Utiliser des IA validées par l’Éducation nationale ou des instances académiques

- Anonymiser systématiquement toutes les données entrées dans les outils

- Former à la protection des données dès le cycle 2, avec des exemples concrets (avatar, pseudonyme…)

- Sensibiliser les élèves : « Ne dites jamais à une IA ce que vous ne diriez pas en public »

💡 Exercice pratique en classe

Faire réfléchir les élèves sur cette question : « Quelles informations personnelles pourriez-vous partager avec un ami, un professeur, un inconnu ? Et avec une IA ? »

Cet exercice aide à comprendre les niveaux de confidentialité et les risques associés.

✍️ Toujours citer ses sources (même quand c’est une IA)

Utiliser ChatGPT pour un texte ? Redmenta pour un quiz ? Super ! Mais n’oublions pas de mentionner l’origine du contenu généré.

Pourquoi ?

- Parce que l’enseignant·e garde la responsabilité intellectuelle de ce qu’il/elle propose

- Et parce qu’une IA ne remplace pas un travail d’analyse ou d’intention pédagogique

💡 Exemple à intégrer

« Ce texte a été généré à partir d’une proposition de ChatGPT (OpenAI), puis adapté, relu et validé par l’autrice. »

🌍 L’IA a une empreinte carbone

C’est un sujet souvent oublié : derrière chaque requête IA se cache un serveur puissant, énergivore, parfois situé à l’autre bout du monde.

💬 À intégrer dans une séquence

- Une carte mentale sur « le coût invisible du numérique »

- Un débat : « Faut-il limiter l’usage de l’IA à l’école ? »

♻️ Une posture responsable

Utiliser l’IA quand elle fait gagner du temps, soutient l’inclusion ou améliore l’expérience pédagogique. Pas pour chaque virgule.

❗️ Désinformation et deep fakes : attention aux pièges

Une IA peut créer de fausses informations crédibles, des images truquées, voire des vidéos montées de toute pièce (les fameux deep fakes).

🎓 Ce que je recommande en classe

- Apprendre à repérer les indices d’un contenu fabriqué

- Organiser des jeux de détection de fake news générées par IA

- Travailler sur la cybercitoyenneté : vérifier avant de partager, prendre du recul, identifier la source

💡 Développer la littératie numérique

La lutte contre la désinformation s’inscrit dans une démarche plus large de littératie numérique. Pour approfondir cette réflexion, je vous invite à consulter : « Pourquoi le numérique à l’école ? »

👥 Préserver l’autonomie professionnelle collective

L’utilisation de l’IA à des fins de préparation de cours peut entraîner une diminution des échanges entre collègues et du travail en collégialité pourtant essentiel à la profession.

⚠️ Risques pour la profession enseignante

Si les enseignants ont de moins en moins le temps d’échanger sur leur discipline ou leurs pratiques pédagogiques, ne conviendrait-il pas de leur donner des conditions de travail permettant de dégager du temps pour ces échanges fructueux ?

- Isolement accru des individus

- Perte de sens du travail

- Diminution de la collégialité

- Risque de déshumanisation de l’activité

✅ Préserver l’agentivité enseignante

La recherche recommande de préserver la capacité des enseignants à prendre eux-mêmes des décisions pédagogiques. Trois pistes concrètes :

- Utiliser l’IA pour améliorer l’information décisionnelle plutôt que prendre des décisions éducatives

- Utiliser l’IA pour des rétroactions formatives et non pour l’évaluation certificative

- Privilégier les usages qui engagent les élèves dans un recul critique sur l’IA

🛡️ Développer les réflexes de protection

Face à l’intimité croissante des échanges avec l’IA, il est essentiel de développer de nouveaux réflexes de protection.

🚨 Les nouvelles vulnérabilités identifiées :

⚠️ L’effet « confident numérique »

Les utilisateurs développent une relation d’intimité avec les IA conversationnelles, oubliant l’absence de protection juridique comparable au secret professionnel.

- Sentiment de « conversation privée » trompeur

- Partage progressif d’informations personnelles

- Vide juridique : OpenAI pourrait être tenu de produire les conversations

✅ Checklist avant tout échange avec une IA

La règle d’or : « Ne partagez jamais avec une IA ce que vous ne diriez pas en public »

Questions à se poser :

- Cette information est-elle vraiment nécessaire pour ma demande ?

- Puis-je reformuler ma question de manière anonyme ?

- Que se passerait-il si cette information était rendue publique ?

- Cette IA respecte-t-elle le RGPD et les standards européens ?

💡 Former les élèves aux « bons gestes »

Activités pédagogiques concrètes :

- Jeu de rôle : « IA detective » – montrer comment reconstituer un profil à partir d’échanges

- Exercice d’anonymisation : réécrire des questions personnelles de manière neutre

- Débat : « Faut-il traiter l’IA comme un ami ou comme un outil ? »

- Analyse : comparer les conditions d’utilisation de différentes IA

🔄 Ce n’est pas magique : c’est réflexif

L’IA peut proposer, suggérer, accélérer… mais c’est toujours l’humain qui choisit, valide et accompagne.

👣 Quelques pistes concrètes

- Partager ses expériences entre collègues (et ses doutes aussi !)

- Créer des documents « avant/après IA » pour montrer l’évolution du travail

- Garder un carnet de bord pour noter ce qui fonctionne… ou pas

⚠️ Responsabilité cognitive

Comme le formule Dominique Bouiller, professeur à Sciences Po : « On a une responsabilité cognitive. Il devrait y avoir des phases de validation, comme pour l’industrie du médicament ».

Il faut faire attention au risque de servitude volontaire face aux systèmes d’IA.

⚖️ Cadre juridique international : les nouveaux repères

🇪🇺 Union européenne – AI Act (1er août 2024)

🚫 Interdictions spécifiques en éducation

- Inférence d’émotions interdite dans l’éducation (sauf raisons médicales)

- Notation sociale des élèves

- Manipulation comportementale cognitive

⚠️ Systèmes « à haut risque » (obligations renforcées)

- Admission et sélection d’élèves

- Évaluation des performances scolaires

- Allocation de ressources éducatives

Exigences : gestion des risques, gouvernance des données, transparence, supervision humaine, DPIA obligatoire.

🌍 Conseil de l’Europe – Convention-cadre sur l’IA (2024)

💡 Premier traité international juridiquement contraignant

Adopté le 17 mai 2024, ouvert à signature le 5 septembre 2024. Ancre les principes de :

- Droits humains et protection des libertés fondamentales

- Transparence et redevabilité des systèmes IA

- Non-discrimination et équité

- État de droit et démocratie

🇫🇷 Focus France – Cadre officiel 2025

Le Ministère de l’Éducation Nationale a publié son cadre d’usage de l’IA en éducation. Pour une analyse détaillée et des conseils pratiques d’application, je vous invite à consulter mon article : « IA à l’école : le cadre officiel Juin 2025 »

✅ Convergence internationale sur 4 principes

- Approche centrée humain avec supervision systématique

- Protection renforcée des données des élèves

- Formation des enseignants à la littératie IA

- Transparence et information des familles

🎯 Les 6 domaines de vigilance identifiés par la recherche

Les recherches internationales convergent sur 6 domaines de vigilance essentiels :

Cliquez pour agrandir le cadre de vigilance

⚠️ Points de vigilance clés

- Protection des données : Minimisation, base légale, DPIA pour les enfants

- Biais & discrimination : Surveillance des performances différenciées

- Transparence : Information sur l’usage d’IA, supervision humaine obligatoire

- Sûreté technique : Robustesse, sécurité des modèles

- Intégrité académique : Gestion des hallucinations, vérification humaine

- Droits de l’enfant : Principe « child-rights by design »

💡 Application du cadre de vigilance

Ce cadre synthétise les recommandations internationales et peut servir de grille d’analyse pour évaluer tout projet d’intégration de l’IA en éducation. Chaque domaine nécessite une attention particulière et des mesures préventives adaptées.

📋 Checklist actionnable pour les établissements

🏛️ Gouvernance & conformité

✅ Actions prioritaires

- Adopter un cadre de management de l’IA (ISO/IEC 42001:2023)

- Cartographier les cas d’usage, risques et contrôles (NIST AI RMF)

- Vérifier si l’usage est « à haut risque » selon l’AI Act

- Proscrire les usages interdits (inférence d’émotions en classe)

📊 Données & contrats

⚠️ Obligations RGPD renforcées

- Minimisation : éviter tout PII dans les prompts

- Hébergement UE privilégié pour les données sensibles

- Clauses contractuelles (DPA) avec fournisseurs EdTech

- Information claire des familles et élèves

- DPIA obligatoire pour systèmes à haut risque

👩🏫 Pédagogie & usages en classe

💡 Bonnes pratiques internationales

- Supervision humaine systématique de tous les contenus générés

- Double vérification des informations produites par l’IA

- Attribution et citation obligatoires des outils utilisés

- Consignes claires sur les usages autorisés et interdits

- Adaptation de l’évaluation : privilégier les productions processuelles

🎓 Formation & culture numérique

✅ Plan de formation obligatoire

- Littératie IA pour enseignants et élèves (biais, limites, confidentialité)

- Guides UNESCO/JRC intégrés aux plans de formation

- Information des familles et publication d’une charte d’établissement

- Formation continue sur les évolutions réglementaires

🎓 Formation des enseignants et cadres techniques

L’intégration éthique de l’IA en éducation nécessite une formation appropriée des enseignants aux enjeux techniques et éthiques.

💡 Lien avec l’éducation au numérique

L’éthique de l’IA s’inscrit dans une démarche plus large d’éducation au numérique. Pour comprendre les enjeux fondamentaux, je vous invite à lire ma réflexion : « Pourquoi le numérique à l’école ? »

✅ Recommandations de la recherche (Romero et al., 2023)

Une approche en 3 étapes pour former à l’éthique de l’IA :

- Découverte : Activités de classe spécifiques sur l’IA

- Apprentissage : Appropriation des enjeux techniques et éthiques

- Agentivité : Développement de l’esprit critique citoyen

💡 Ma recommandation pour la formation continue

J’encourage fortement l’intégration de la formation à l’éthique de l’IA dans les parcours de développement professionnel des enseignants pour garantir un usage responsable et éclairé.

🔧 Pour les établissements avancés

Des normes comme le NIST AI RMF 1.0 (gratuit) et ISO/IEC 42001:2023 permettent de structurer la gouvernance IA dans les grandes institutions.

🧠 Développer l’esprit critique : une approche scientifique

La recherche propose des modèles concrets pour enseigner l’usage critique de l’IA.

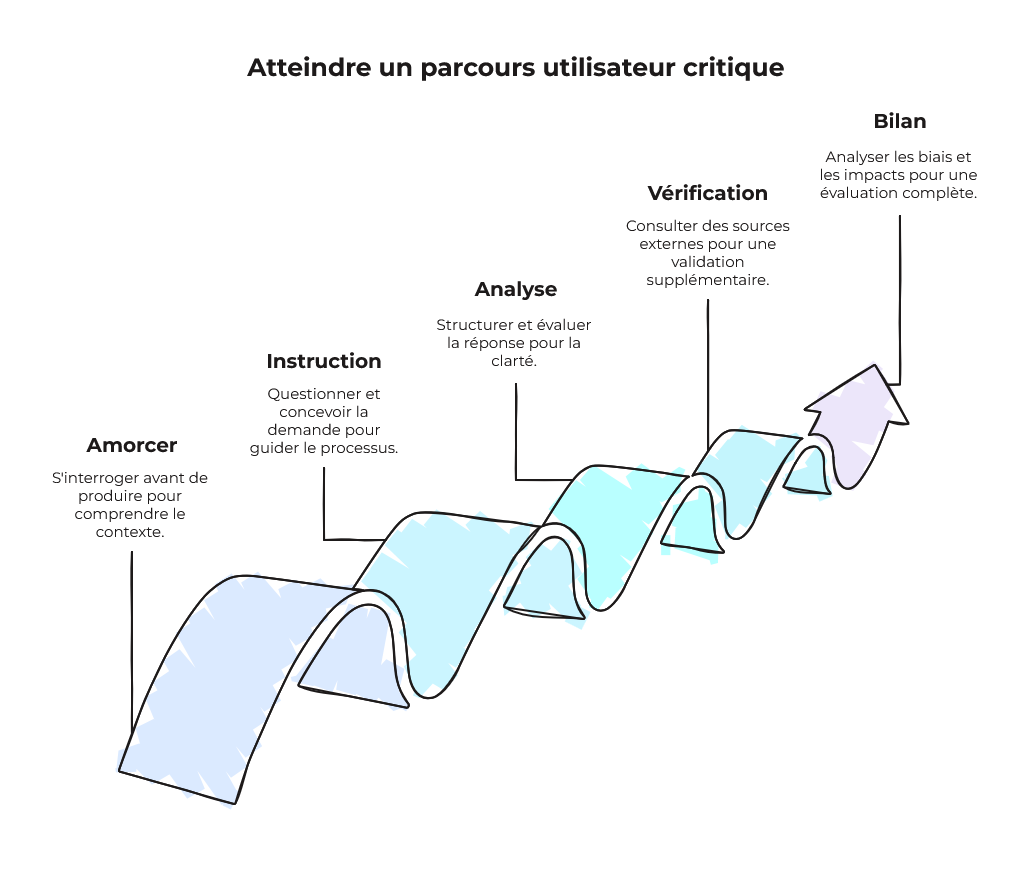

💡 Les 5 étapes essentielles

- Amorce : S’interroger avant de produire

- Instruction : Questionner et concevoir sa demande

- Analyse : Structurer et évaluer la réponse obtenue

- Vérification : Consulter des sources externes complémentaires

- Bilan : Analyser les biais et impacts de l’interaction

Cliquez pour agrandir le schéma

✅ Message clé pour les élèves

« Tu as utilisé intelligemment l’IA, c’est bien » – Cette validation positive encourage l’usage réflexif plutôt que l’interdiction.

🔧 Normes techniques et certification

Des cadres normatifs émergent pour structurer la gouvernance de l’IA dans les organisations éducatives.

NIST AI RMF 1.0

Cadre de gestion des risques IA (cartographier, mesurer, gérer)

🇺🇸 US StandardISO/IEC 42001:2023

Système de management de l’IA (norme certifiable)

🌍 International💡 Avantages pour les établissements

Ces normes permettent de :

- Structurer la gouvernance IA (politique, rôles, responsabilités)

- Mettre en place des évaluations de risques systématiques

- Assurer une amélioration continue des pratiques

- Démontrer la conformité aux partenaires et autorités

✅ Ma recommandation pour académies et universités

Je conseille de considérer l’adoption progressive de ces standards, en commençant par le NIST AI RMF (gratuit) pour structurer l’approche risques, puis évoluer vers la certification ISO/IEC 42001 pour les établissements les plus avancés.

✨ Transformer la fascination en sagesse pédagogique

C’est bien de cela qu’il s’agit : passer de l’émerveillement initial à une utilisation réfléchie et éthique de l’IA en éducation.

Cliquez pour agrandir le schéma

💭 Réflexion clé

L’IA ne remplace pas l’humain, mais amplifie les capacités lorsqu’elle est utilisée avec discernement et dans un cadre éthique approprié. Le passage de la fascination à la sagesse pédagogique nécessite du temps, de la formation et une réflexion collective.

✅ Les étapes de cette transformation

- Émerveillement initial : Découverte des capacités de l’IA

- Prise de recul : Identification des limites et des risques

- Formation : Acquisition des compétences techniques et éthiques

- Usage réfléchi : Intégration pédagogique raisonnée

- Sagesse collective : Partage d’expériences et amélioration continue

📋 En résumé…

L’IA peut devenir une alliée dans les pratiques pédagogiques, à condition de :

✅ Checklist de bonnes pratiques

- Former les élèves à l’esprit critique numérique

- Protéger les données personnelles à chaque étape

- Privilégier les outils conçus pour l’éducation

- Prendre le temps de réfléchir, tester, ajuster

- Garder le contrôle, toujours

📚 Références principales

🎯 Mon dossier complet IA & Éducation

Pour approfondir tous les aspects de l’IA en éducation (prompting, outils, bonnes pratiques, activités élèves…), je vous invite à consulter mon dossier complet « L’I.A. en éducation » avec de nombreuses ressources pratiques.

Sources institutionnelles clés :

- UNESCO – Recommandations IA et éducation

- CNIL – L’IA en questions

- PIX – Culture numérique et cybersécurité

- Ministère de l’Éducation Nationale (2023). IA et éducation : apports de la recherche. Direction du Numérique pour l’Éducation.

Recherche académique :

- Allouche, E. (2023). Modélisation de parcours utilisateur critique avec un agent conversationnel. GTnum, Ministère de l’Éducation Nationale.

- Romero, M. et al. (2021). Enseigner et apprendre à l’ère de l’intelligence artificielle. GTnum, Ministère de l’Éducation Nationale.

- INRIA – Équipes ORPAILLEUR et PRIVATICS – Recherche sur l’IA éthique

- Lepage, A. & Collin, S. (2023). Préserver l’agentivité des enseignants et élèves : des pistes issues d’une recension des écrits. GTnum.

🛠️ Ressources pratiques pour l’éthique de l’IA

🎯 Mon dossier complet IA & Éducation

Pour approfondir tous les aspects de l’IA en éducation (prompting, outils, bonnes pratiques, activités élèves…), je vous invite à consulter mon dossier complet « L’I.A. en éducation » avec de nombreuses ressources pratiques.

💡 Formation continue que je recommande

J’encourage à intégrer la sensibilisation à l’éthique de l’IA dans les programmes de formation continue des enseignants pour développer les compétences nécessaires à un usage responsable.

🚀 Prêt(e) à explorer l’IA en éducation de manière éthique ?

Découvrez mes autres ressources pour une intégration responsable de l’intelligence artificielle

Laisser un commentaire